英伟达选定美光科技作为SOCAMM内存首家供应商

发布时间:2025-6-17 15:12

发布者:eechina

|

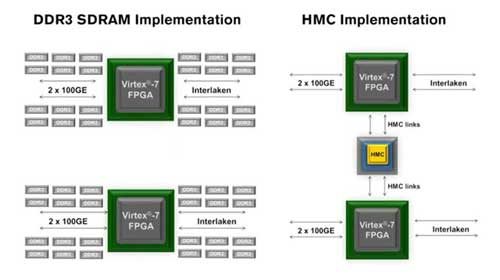

英伟达(NVIDIA)近日正式宣布,选定美光科技(Micron Technology)作为其下一代内存解决方案SOCAMM(Small Outline Compression Attached Memory Module)的首家量产供应商。这一决定标志着美光在数据中心内存技术领域的重大突破,其基于LPDDR5X芯片的SOCAMM模块凭借能效比竞品高出20%的核心优势,击败三星电子、SK海力士等传统巨头,成为英伟达AI加速器平台Rubin的关键组件供应商。 技术突破:能效与散热双优,重塑AI内存架构 SOCAMM被业界视为“第二代高带宽存储器(HBM)”,专为数据中心AI服务器设计,旨在优化CPU与AI工作负载的协同效率。与垂直堆叠的HBM不同,SOCAMM采用铜互连技术连接16个DRAM芯片,显著提升散热性能,这对高密度部署的AI服务器至关重要。 美光展示的SOCAMM模块规格如下: 容量:128GB(基于4颗16层堆叠的16Gb DRAM芯片) 带宽:支持8533 MT/s数据速率,是DDR5的2.5倍 能效:功耗仅为传统内存的1/3,服务器整机能耗降低45% 可扩展性:支持热插拔升级,模块尺寸仅90mm×14mm,适配液冷系统 据英伟达测试,搭载SOCAMM的服务器在运行6700亿参数大模型时,数据加载时间缩短40%,训练周期可减少15天。这一性能提升源于SOCAMM与HBM3E的协同架构:Rubin平台将配置288GB HBM3E(核心计算)与40TB SOCAMM(边缘推理),构建“高低速内存协同体系”。 竞争格局:美光技术路线差异化制胜 英伟达曾委托三星、SK海力士与美光共同开发SOCAMM原型,但美光率先通过验证流程。其核心优势在于: 低功耗设计:LPDDR5X芯片能效比竞品高20%,每台AI服务器搭载4个SOCAMM模块(总计256个DRAM芯片)时,散热效率优势尤为突出。 散热管理创新:采用引线键合和铜互连技术,避免HBM依赖硅通孔(TSV)导致的热堆积问题,提升系统稳定性。 量产成熟度:美光已宣布SOCAMM与HBM3E同步进入量产阶段,而三星等韩企的SOCAMM芯片尚未获英伟达认证。 行业分析师指出,美光的胜出反映了AI存储技术从“单纯堆叠”向“能效与散热平衡”的范式转变。随着HBM4研发推进(美光已启动先进制程base die设计),热管理将成为下一代存储芯片的核心竞争力。 市场影响:美光巩固高端存储领导地位 此次合作对美光意义重大: 财务层面:2025财年HBM销售额突破10亿美元,环比激增50%,SOCAMM的加入将进一步扩大其在AI数据中心市场的份额。 技术路线:美光成为全球首家同时出货HBM3E和SOCAMM的存储厂商,其双轨战略(HBM满足GPU需求,SOCAMM支撑CPU与边缘推理)已获英伟达、AMD等核心客户认可。 产能布局:美光计划2025年投入140亿美元资本支出,扩建新加坡、日本及纽约州HBM工厂,为长期订单提供保障。 对于英伟达而言,SOCAMM的引入将加速其AI平台迭代:Rubin平台计划于2026年发布,支持冷板+浸没双模式液冷,算力密度提升1.5倍,同等功耗下性能提升30%。此外,SOCAMM的可扩展性或使其延伸至英伟达个人超级计算机项目DIGITS,推动AI技术向边缘场景渗透。 |

网友评论