毫无疑问,边缘智能正在崛起,低功耗AI芯片才是未来!(一)

发布时间:2018-1-12 11:46

发布者:eaoogle_WSN

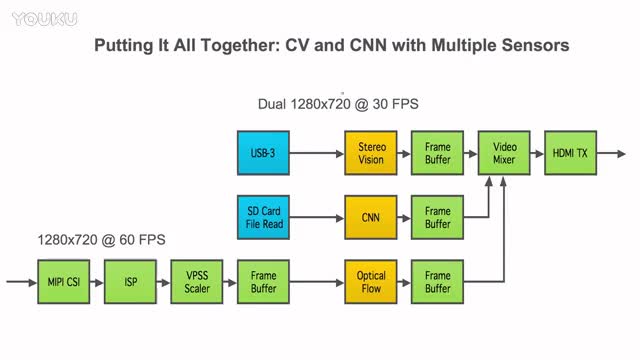

------ 【导读】------云端AI存在1.功耗过高;2.实时性不强;3.带宽不足;4.安全问题......因此,越来越多的AI初创企业将终端专用芯片作为重点攻克课题。毫无疑问,越来越多的计算未来将会在终端设备上完成,智能将会下沉到终端设备,智能边缘计算将会崛起。目前,国内外已经有诸多芯片或人工智能公司加入了研发低功耗AI芯片的大军,本文对此进行盘点。 阿尔法狗的横空出世如同平地里起的一声惊雷,让“人工智能(AI)”这个并不算新的概念以强横之姿重新霸占了大众视野。以此为爆点,深度学习技术在图像识别、自然语言处理等方向上取得了前所未有的成功,并推动相关行业的快速发展,人脸识别、智能音箱等应用已经在人们的生活中变得稀松平常。 纵观人工智能产业链,基础层、算法层和应用层是缺一不可的三个组成部分。但是考虑到深度学习等AI算法开源的发展趋势,基础层的数据与AI芯片才是未来竞争的战略高地。 专用于人工智能的芯片和传统的计算芯片存在很大的差异——典型CPU的架构中需要大量的空间去放置存储单元和控制单元,相比之下计算单元只占据了很小的一部分,算力无法满足深度神经网络(DNN)的计算需求;而AI芯片则具有大量的计算单元,能够适合大规模并行计算的需求。  CPU微架构示意图,图中绿色部分表示计算单元,可以明显的看出只占了很小一部分  GPU(AI芯片三大类之一)微架构示意图,有数量众多的计算单元和超长的流水线,特别适合处理大量的类型统一的数据 基于通用性与计算性能的不同,可以把AI芯片分为GPU、FPGA、ASIC三大类。 芯片 简介 特点 主要厂商 GPU GPU最初是用在个人电脑、工作站、游戏机和一些移动设备上运行绘图运算工作的微处理器。虽然GPU是为了图像处理而生的,但是它在结构上并没有专门为图像服务的部件,只是对CPU的结构进行了优化与调整,所以GPU不仅可以在图像处理领域大显身手,它还被用来科学计算、密码破解、数值分析,海量数据处理(排序,Map-Reduce等),金融分析等需要大规模并行计算的领域。 1.无法单独工作,必须由CPU进行控制调用才能工作 2.功耗高 英伟达 AMD FPGA FPGA是算法即电路,软硬合一的芯片。基于硬件描述语言,可以把算法逻辑直接编译为晶体管电路组合。由于FPGA的硬件电路是由算法定制的,其不需要取指令与指令译码过程,因而,FPGA能够充分发挥芯片的计算能力。 1.FPGA可以重复编程,因而具备一定的灵活性 2.效率高,功耗低 赛灵思 英特尔 ASIC 依产品需求不同而定制化的特殊规格集成电路,由特定使用者要求和特定电子系统的需要而设计、制造,简单来说就是定制化芯片。近年来涌现的类似TPU、NPU、VPU、BPU等令人眼花缭乱的各种芯片,本质上都属于ASIC。 1.更加符合专业需求 2.从性能、面积、功耗等各方面,AISC都优于GPU和FPGA,但价格昂贵 谷歌 英特尔 寒武纪 地平线 异构智能 我们知道,深度学习分为两个阶段:模型训练与智能推断。现阶段,由于终端设备的计算力普遍有限,模型训练与推断大都在云端服务器上完成。在云端模型训练中,英伟达的GPU占主导地位 但随着应用的不断拓展,大家发现,云端AI存在很多问题: 1.功耗过高:与云端进行大量的数据传输将产生极大的功耗,限制了终端设备的应用。以目前火爆的比特币“挖矿”为例,矿工们过去都是采用英伟达的GPU,但是耗电太大,需要支付高昂的电费,这笔费用会稀释矿工们的利润,因此他们开始越来越多转向ASIC专用集成电路。 2.实时性不强:本地数据通过网络传输到云端,云端再将计算结果返回终端,这一过程存在数秒乃至数十秒的延迟。但在自动驾驶领域,毫秒级的延迟就可能造成重大安全事故,是无法被容忍的;在制造业领域,工厂停产的损失也是论秒计的,延迟可能会让数据价值呈现断崖式下跌。 3.带宽不足:传感器的大范围普及和低功耗广域网等连接技术的飞速发展,催化了物联网设备的爆炸式增长。市场研究公司Gartner称,2017年全球物联网设备数量将达到84亿——比2016年的64亿增长31%,而全球人口数量为75亿,也就是说2017年物联网设备数量将首次超过全球人口。到了2020年,物联网设备数量将达到204亿。可以预想,未来网络带宽的拓展速度远远低于智能互联产品的增长速度,无法满足云端互联的带宽需求。 4.安全问题:网络传输过程中存在数据被劫持的风险,隐私与安全性缺乏保障。 基于此,越来越多的AI初创企业将终端专用芯片作为重点攻克课题,以解决云端连接存在的功耗、延迟、带宽、隐私等问题——毫无疑问,越来越多的计算未来将会在终端设备上完成,智能将会下沉到终端设备,智能边缘计算将会崛起。 实时性是选择在终端完成推断最主要的原因之一;但由于深度学习的计算量巨大,所以算力也不能落下;再者,电池供电的终端设备对功耗也有极高的要求,且大多数的终端产品价格敏感。总之,高性能、低功耗、低成本的AI芯片将会是未来的主流。 目前,国内外已经有诸多芯片或人工智能公司加入了研发低功耗AI芯片的大军,现盘点如下: ——国内篇—— 寒武纪 “寒武纪”成立于2016年,是北京中科寒武纪科技有限公司的简称,由中科院计算所孵化,于2017年8月获得了国投、阿里巴巴、联想等共计1亿美元融资,成为估值近10亿美元的智能芯片领域独角兽公司。寒武纪主要面向深度学习等人工智能关键技术进行专用芯片的研发,可用于云服务器和智能终端上的图像识别、语音识别、人脸识别等应用。  公司未来的愿景是让人工智能芯片计算效率提高一万倍,功耗降低一万倍。为了实现这一目标,寒武纪AI芯片能在计算机中模拟神经元和突触的计算,对信息进行智能处理,还通过设计专门存储结构和指令集,每秒可以处理160亿个神经元和超过2万亿个突触,功耗却只有原来的十分之一。未来甚至有希望把类似Alpha Go的系统都装进手机,让手机帮助我们做各种各样的事情,甚至通过长期的观察和学习,真正实现强大的智能。 2016,寒武纪发布了世界上第一个商用深学习处理器IP,即寒武纪1A处理器。2017年,寒武纪授权华为海思使用寒武纪1A处理器,搭载于麒麟970芯片和Mate 10系列手机中。 2017年11月,寒武纪在北京发布了三款新一代人工智能芯片,分别为面向低功耗场景视觉应用的寒武纪1H8,高性能且拥有广泛通用性的寒武纪1H16,以及用于终端人工智能和智能驾驶领域的寒武纪1M。 芯片 应用领域 说明 寒武纪1H8处理器 低功耗场景视觉 有4种配置可选,主打拍照辅助、图片处理、安防监控,性能功耗比是1A处理器的2.3倍 寒武纪1H16处理器 广泛通用性 1A处理器的升级版,拥有更高性能 寒武纪1M处理器 智能驾驶 性能是1A处理器的10倍以上 地平线 地平线机器人(Horizon Robotics)由前百度深度学习研究院负责人余凯创办,致力于打造基于深度神经网络的人工智能“大脑”平台。2017年10月,这家公司拿到了英特尔、嘉实投资、高翎资本、红杉资本等近亿美元的A+轮投资。 地平线的商业模式是芯片+算法,希望为客户提供低功耗、本地化的方案,以解决环境感知、人机交互、决策控制等问题。 软件方面,地平线做了一套基于神经网络的OS,已经研发出分别面向自动驾驶的的“雨果”平台和智能家居的“安徒生”平台,并开始逐步落地;硬件方面,未来地平线机器人还会为这个平台设计一个芯片——NPU(Neural Processing Unit),支撑自家的OS,到那时效能会提升2-3个数量级(100-1000倍)。地平线的最终产品不止芯片,而是一个核心控制模块,具有感知、识别、理解、控制的功能。  据羿戓信息所了解,2017年12月20日,地平线在北京举行首次芯片产品发布会,推出了面向自动驾驶的嵌入式AI视觉芯片“征程”和面向智能摄像头嵌入式AI视觉芯片“旭日”。 芯片 特点 应用 征程 ·高性能:一路1080P@30fps的视频输入,可对毎帧图像中的200个目标进行检测识别 ·低功耗:典型功耗仅为1.5W·低延时:小于30ms 能够同时对行人、机动车、非机动车、车道线、交通标志牌、红绿灯等8类目标进行精准的实时检测和识别。 旭日 集合先进深度学习算法,能够在前端实现大规模人脸检测跟踪、视频结构化等应用,可用于安防、智慧城市等场景 除此之外,在本次发布会上,地平线还面向智能驾驶、智慧城市、商业智能三大场景客户提供了“算法+芯片+云”的解决方案,在原来提及的“芯片+算法”的基础上加上了“云”。 深鉴科技 深鉴科技由清华团队创办,目标是以ASIC级别的功耗,来达到优于GPU的性能。自2016年3月成立以来,深鉴科技已经获得了天使到A+轮的3轮融资,累计融资金额超1亿美金,投资方包括金沙江创投、高榕资本、Xilinx、联发科、清华控股、蚂蚁金服、三星风投等。 如今,深鉴科技已成长为一家具备神经网络压缩编译工具链、深度学习处理器DPU设计、FPGA开发与系统优化等技术能力的初创公司。其中,最为核心的,即为DPU(Deep Learning Processing Unit),以及神经网络压缩编译技术,它不仅可以将神经网络压缩数十倍而不影响准确度,还可以使用“片上存储”来存储深度学习算法模型,减少内存读取,大幅度减少功耗。目前,深鉴科技的产品主要应用于安防监控与数据中心两大领域。 2017年10月,深鉴科技正式召开了第一次发布会,推出了六款AI产品,分别是人脸检测识别模组、人脸分析解决方案、视频结构化解决方案、ARISTOTLE架构平台,深度学习SDK DNNDK、双目深度视觉套件。 芯片方面,则公布了最新的芯片计划,由深鉴自主研发的芯片“听涛”、“观海”将于2018年第三季度面市。其中,“听涛”系列芯片,采用台积电28纳米制程,核心使用深鉴自己的亚里士多德架构,峰值性能1.1瓦 4.1 TOPS,预计将于上半年完成产品装载。  从官方提供的数据来看,其嵌入式端的产品在性能超过Nvidia TK1 的同时,功耗、售价仅为后者的1/4左右。服务器端的产品,性能接近Nvidia K40 GPU ,但功耗只有35瓦左右,售价300美元以下,不足后者的1/10。这些产品将主要应用在无人机、安防监控、机器人、AR等领域,目前已经与一家知名无人机厂商建立了合作。 |

网友评论